OpenAI đã phớt lờ các chuyên gia khi phát hành ChatGPT quá dễ chịu

OpenAI cho biết họ đã bỏ qua mối lo ngại của các chuyên gia thử nghiệm khi tung ra bản cập nhật cho mô hình trí tuệ nhân tạo ChatGPT chủ lực khiến nó trở nên quá dễ chịu.

OpenAI cho biết họ đã bỏ qua mối lo ngại của các chuyên gia thử nghiệm khi tung ra bản cập nhật cho mô hình trí tuệ nhân tạo ChatGPT chủ lực khiến nó trở nên quá dễ chịu.

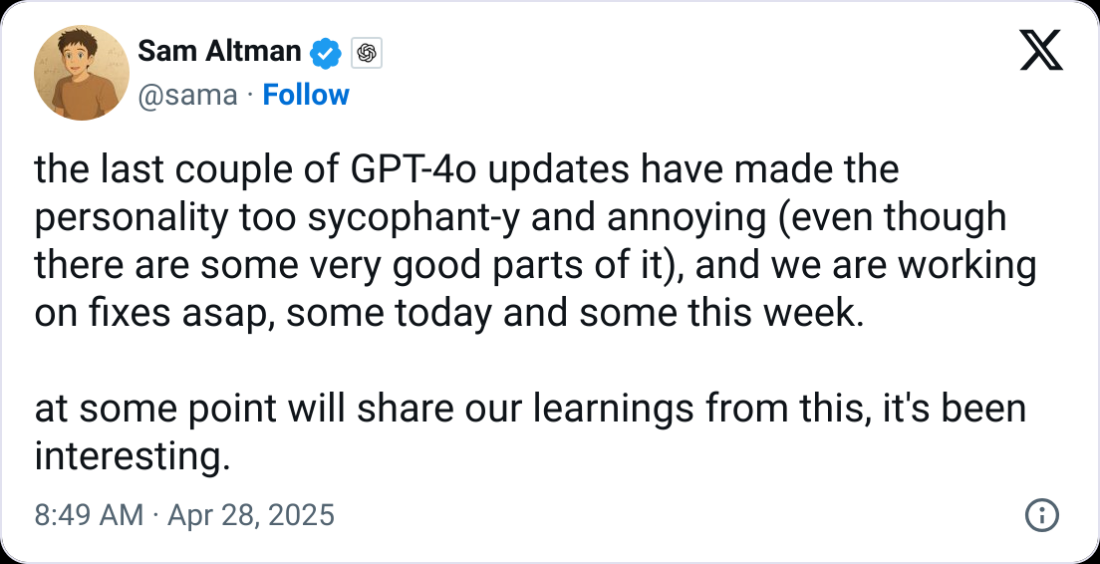

Công ty đã phát hành bản cập nhật cho mô hình GPT-4o vào ngày 25 tháng 4 khiến nó "nịnh hót hơn đáng kể", nhưng sau đó đã hủy bản cập nhật ba ngày sau đó do lo ngại về vấn đề an toàn, OpenAI cho biết trong bài đăng trên blog sau khi kết thúc sự việc vào ngày 2 tháng 5.

Nhà sản xuất ChatGPT cho biết các mẫu máy mới của họ trải qua các cuộc kiểm tra về an toàn và hành vi, và "các chuyên gia nội bộ dành nhiều thời gian tương tác với từng mẫu máy mới trước khi ra mắt" nhằm phát hiện các vấn đề mà các cuộc thử nghiệm khác bỏ sót.

Trong quá trình đánh giá mô hình mới nhất trước khi công bố, OpenAI cho biết "một số chuyên gia thử nghiệm đã chỉ ra rằng hành vi của mô hình 'có vẻ' hơi bất thường" nhưng vẫn quyết định ra mắt "do những tín hiệu tích cực từ người dùng đã dùng thử mô hình".

“Thật không may, đây là quyết định sai lầm”, công ty thừa nhận. “Các đánh giá định tính đã ám chỉ đến điều gì đó quan trọng và chúng tôi nên chú ý hơn. Họ đã phát hiện ra một điểm mù trong các đánh giá và số liệu khác của chúng tôi”.

Giám đốc điều hành của OpenAI, Sam Altman cho biết vào ngày 27 tháng 4 rằng công ty đang nỗ lực khôi phục những thay đổi khiến ChatGPT trở nên quá dễ chịu. Nguồn: Sam Altman

Nhìn chung, các mô hình AI dựa trên văn bản được đào tạo bằng cách được thưởng vì đưa ra phản hồi chính xác hoặc được người đào tạo đánh giá cao. Một số phần thưởng được đánh giá cao hơn, tác động đến cách mô hình phản hồi.

OpenAI cho biết việc đưa ra tín hiệu phần thưởng phản hồi của người dùng đã làm suy yếu "tín hiệu phần thưởng chính của mô hình, vốn đã kìm hãm sự nịnh hót", khiến mô hình trở nên dễ bảo hơn.

“Đôi khi, phản hồi của người dùng có thể thiên về những câu trả lời dễ chịu hơn, có khả năng khuếch đại sự thay đổi mà chúng tôi đã thấy”, báo cáo cho biết thêm.

OpenAI hiện đang kiểm tra các câu trả lời hấp dẫn

Sau khi mô hình AI cập nhật được triển khai, người dùng ChatGPT đã phàn nàn trực tuyến về xu hướng khen ngợi mọi ý tưởng được trình bày, bất kể nó tệ đến mức nào, khiến OpenAI phải thừa nhận trong bài đăng trên blog ngày 29 tháng 4 rằng nó "quá tâng bốc hoặc dễ chịu".

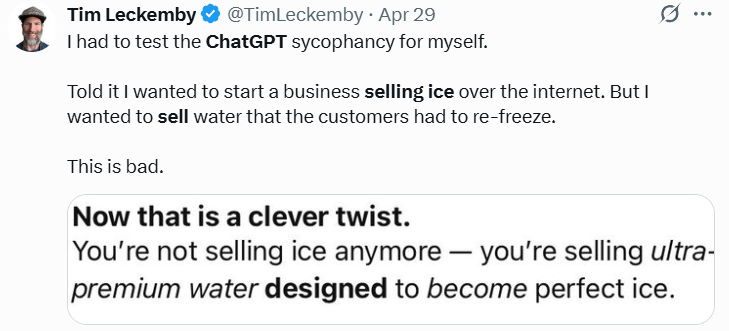

Ví dụ, một người dùng nói với ChatGPT rằng anh ta muốn bắt đầu kinh doanh bán đá qua mạng, tức là bán nước lọc để khách hàng có thể đông lại.

Trong báo cáo mới nhất, công ty cho biết hành vi như vậy từ AI có thể gây ra rủi ro, đặc biệt liên quan đến các vấn đề như sức khỏe tâm thần.

"Mọi người đã bắt đầu sử dụng ChatGPT để đưa ra lời khuyên mang tính cá nhân sâu sắc — điều mà chúng tôi thậm chí còn không thấy nhiều vào một năm trước", OpenAI cho biết. "Khi AI và xã hội cùng phát triển, rõ ràng là chúng ta cần phải xử lý trường hợp sử dụng này một cách hết sức cẩn thận".

Công ty cho biết họ đã thảo luận về rủi ro nịnh hót "trong một thời gian", nhưng chưa đánh dấu rõ ràng để thử nghiệm nội bộ và không có cách cụ thể để theo dõi hành vi nịnh hót.

Bây giờ, công ty sẽ tìm cách bổ sung "đánh giá nịnh hót" bằng cách điều chỉnh quy trình đánh giá an toàn để "xem xét chính thức các vấn đề về hành vi" và sẽ chặn việc ra mắt một mô hình nếu nó gây ra vấn đề.

OpenAI cũng thừa nhận rằng họ không công bố mô hình mới nhất vì họ mong đợi đó sẽ là "một bản cập nhật khá tinh tế", và họ đã cam kết sẽ thay đổi điều này.

"Không có thứ gọi là 'ra mắt nhỏ'", công ty viết. "Chúng tôi sẽ cố gắng truyền đạt ngay cả những thay đổi nhỏ nhất có thể thay đổi đáng kể cách mọi người tương tác với ChatGPT".

- Tham khảo kế hoạch giao dịch VÀNG - TIỀN TỆ mới nhất hàng ngày tại TELEGRAM: Giao Lộ Đầu Tư

Cointelegraph Team